资讯专栏INFORMATION COLUMN

摘要:三人造神经元工作原理及电路实现人工神经网络人工神经网络,缩写,简称神经网络,缩写,是一种模仿生物神经网络的结构和功能的数学模型或计算模型。神经网络是一种运算模型,由大量的节点或称神经元,或单元和之间相互联接构成。

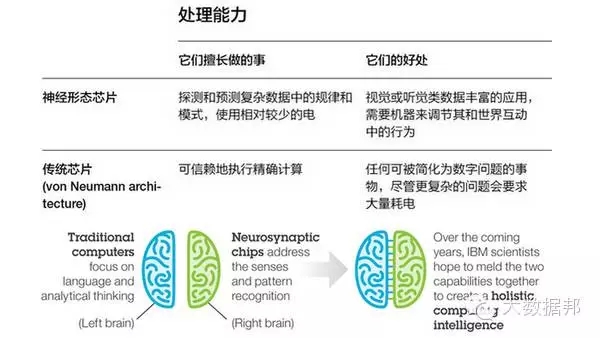

一、与传统计算机的区别

1946年美籍匈牙利科学家冯·诺依曼提出存储程序原理,把程序本身当作数据来对待。此后的半个多世纪以来,计算机的发展取得了巨大的进步,但“冯·诺依曼架构”中信息存储器和处理器的设计一直沿用至今,连接存储器和处理器的信息传递通道仍然通过总线来实现。随着处理的数据量海量地增长,总线有限的数据传输速率被称为“冯·诺依曼瓶颈”——尤其是移动互联网、社交网络、物联网、云计算、高通量测序等的兴起,使得‘冯·诺依曼瓶颈’日益突出,而计算机的自我纠错能力缺失的局限性也已成为发展障碍。

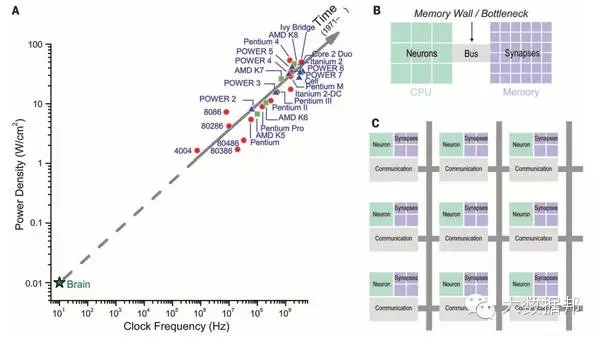

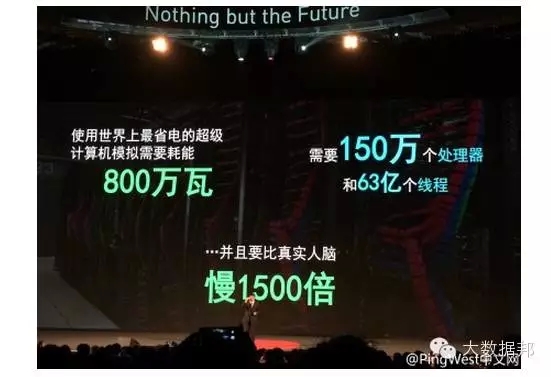

结构上的缺陷也导致功能上的局限。例如,从效率上看,计算机运算的功耗较高——尽管人脑处理的信息量不比计算机少,但显然而功耗低得多。为此,学习更多层的神经网络,让计算机能够更好地模拟人脑功能,成为上世纪后期以来研究的热点。

在这些研究中,核心的研究是“冯·诺依曼架构”与“人脑架构”的本质结构区别——与计算机相比,人脑的信息存储和处理,通过突触这一基本单元来实现,因而没有明显的界限。正是人脑中的千万亿个突触的可塑性——各种因素和各种条件经过一定的时间作用后引起的神经变化(可变性、可修饰性等),使得人脑的记忆和学习功能得以实现。

大脑有而计算机没有的三个特性:低功耗(人脑的能耗仅约20瓦,而目前用来尝试模拟人脑的超级计算机需要消耗数兆瓦的能量);容错性(坏掉一个晶体管就能毁掉一块微处理器,但是大脑的神经元每时每刻都在死亡);还有不需为其编制程序(大脑在与外界互动的同时也会进行学习和改变,而不是遵循预设算法的固定路径和分支运行。)

这段描述可以说是“电”脑的最终理想了吧。

注:最早的电脑也是模拟电路实现的,之后发展成现在的只有0、1的数字CPU。

今天的计算机用的都是所谓的冯诺依曼结构,在一个中央处理器和记忆芯片之间以线性计算序列来回传输数据。这种方式在处理数字和执行较精确撰写的程序时非常好用,但在处理图片或声音并理解它们的意义时效果不佳。

有件事很说明问题:2012年,谷歌展示了它的人工智能软件在未被告知猫是什么东西的情况下,可以学会识别视频中的猫,而完成这个任务用到了1.6万台处理器。

要继续改善这类处理器的性能,生产商得在其中配备更多更快的晶体管、硅存储缓存和数据通路,但所有这些组件产生的热量限制了芯片的运作速度,尤其在电力有限的移动设备中。这可能会阻碍人们开发出有效处理图片、声音和其他感官信息的设备,以及将其应用于面部识别、机器人,或者交通设备航运等任务中。

神经形态芯片尝试在硅片中模仿人脑以大规模的平行方式处理信息:几十亿神经元和千万亿个突触对视觉和声音刺激物这类感官输入做出反应。

作为对图像、声音等内容的反应,这些神经元也会改变它们相互间连接的方式,我们把这个过程叫做学习。神经形态芯片纳入了受人脑启发的“神经网路”模式,因此能做同样的事。

人工智能的顶尖思想家杰夫·霍金斯(Jeff Hawkins)说,在传统处理器上用专门的软件尝试模拟人脑(谷歌在猫实验中所做的),以此作为不断提升的智能基础,这太过低效了。

霍金斯创造了掌上电脑(Palm Pilot),后来又联合创办了Numenta公司,后者制造从人脑中获得启发的软件。“你不可能只在软件中建造它,”他说到人工智能,“你必须在硅片中建造它。”

现有的计算机计算,程序的执行是一行一行执行的,而神经网络计算机则有所不同。

現行的人工智能程式,基本上都是將大大小小的各種知識寫成一句一句的陳述句,再灌進系統之中。當輸入問題進去智能程式時,它就會搜尋本身的資料庫,再選擇出较佳或最近解。2011年時,IBM 有名的 Watson 智能電腦,便是使用這樣的技術,在美國的電視益智節目中打敗的人類的最強衛冕者。

(神经网络计算机)以这种异步信号发送(因没有能使其同步的中央时钟而得名)处理数据的速度比同步信号发送更快,以为没有时间浪费在等待时钟发出信号上。异步信号发送消耗的能量也更少,这样便满足了迈耶博士理想的计算机的第一个特点。如果有一个处理器坏了,系统会从另一路线绕过它,这样便满足了迈耶博士理想的计算机的第二个特点。正是由于为异步信号发送编程并不容易,所以大多数计算机工程师都无视于此。然而其作为一种模仿大脑的方式堪称完美。

功耗方面:

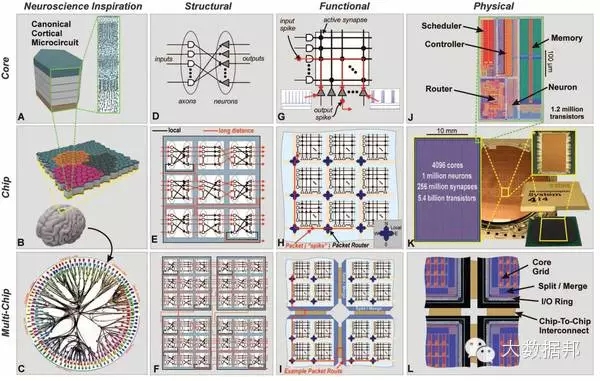

硬件方面,近年来主要是通过对大型神经网络进行仿真,如 Google 的深度学习系统Google Brain,微软的Adam等。但是这些网络需要大量传统计算机的集群。比方说 Google Brain 就采用了 1000 台各带 16 核处理器的计算机,这种架构尽管展现出了相当的能力,但是能耗依然巨大。而 IBM 则是在芯片上的模仿。4096 个内核,100 万个“神经元”、2.56 亿个“突触”集成在直径只有几厘米的方寸(是 2011 年原型大小的 1/16)之间,而且能耗只有不到 70 毫瓦。

IBM 研究小组曾经利用做过 DARPA 的NeoVision2 Tower数据集做过演示。它能够实时识别出用 30 帧每秒的正常速度拍摄自斯坦福大学胡佛塔的十字路口视频中的人、自行车、公交车、卡车等,准确率达到了 80%。相比之下,一台笔记本编程完成同样的任务用时要慢 100 倍,能耗却是 IBM 芯片的 1 万倍。

Ref: A million spiking-neuron integrated circuit with a Scalable communication network and interface. Paul A. Merolla et al. Science 345, 668 (2014); DOI: 10.1126/science.1254642

因为需要拥有极多数据的Database 来做training以及需要极强大的计算能力来做prediction,现有的一些Deep learning如Andrew Ng的Google Brain、Apple的Siri等都需要连接网络到云端的服务器。

二、争议:

雖然深度學習已經被應用到尖端科學研究及日常生活當中,而 Google 已經實際搭載在核心的搜尋功能之中。但其他知名的人工智能實驗室,對於深度學習技術的反應並不一致。例如艾倫人工智慧中心的執行長 Oren Etzioni,就沒有考慮將深度學習納入當前開發中的人工智慧系統中。該機構目前的研究是以小學程度的科學知識為目標,希望能開發出光是看學校的教科書,就能夠輕鬆應付各類考試的智能程式。Oren Etzioni 以飛機為例,他表示,最成功的飛機設計都不是來自於模仿鳥的結構,所以腦神經的類比並無法保證人工智能的實現,因此他們暫不考慮借用深度學習技術來開發這個系統。

但是从短期来看,情况也许并没有那么乐观。

首先芯片的编程仍然是个大问题。芯片的编程要考虑选择哪一个神经元来连接,以及神经元之间相互影响的程度。比方说,为了识别上述视频中的汽车,编程人员首先要对芯片的仿真版进行必要的设置,然后再传给实际的芯片。这种芯片需要颠覆以往传统的编程思想,尽管 IBM 去年已经发布了一套工具,但是目前编程仍非常困难,IBM 团队正在编制令该过程简单一点的开发库。(当然,如果我们回顾过去编程语言从汇编一路走来的历史,这一点也许不会成为问题。)

其次,在部分专业人士看来,这种芯片的能力仍有待证实。

再者,真正的认知计算应该能从经验中学习,寻找关联,提出假设,记忆,并基于结果学习,而IBM 的演示里所有学习(training)都是在线下的冯诺依曼计算机上进行的。不过目前大多数的机器学习都是离线进行的,因为学习经常需要对算法进行调整,而 IBM 的硬件并不具备调整的灵活性,不擅长做这件事情。

三、人造神经元工作原理及电路实现

人工神经网络

人工神经网络(artificial neural network,缩写ANN),简称神经网络(neural network,缩写NN),是一种模仿生物神经网络的结构和功能的数学模型或计算模型。

神经网络是一种运算模型,由大量的节点(或称“神经元”,或“单元”)和之间相互联接构成。每个节点代表一种特定的输出函数,称为激励函数(activation function)。每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重(weight),这相当于人工神经网络的记忆。网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

Ref:Wikipedia: 人工神经网络

电路原理

神经递质的分泌反过来又是对动作电位刺激的反应。然而神经元在接收到这些神经递质信号中的一个后便不会再继续发出动作电位。当然,它们会逐渐累加至一个极限值。在神经元接受了一定数量的信号并超过极限值后----从根本上讲是一个模拟进程----然后它们会发出一个动作电位,并自行重置。Spikey的人造神经元也是这么做的,当它们每次受到激发时都会在电容中累积电荷,直至达到限值,电容再进行放电。

具体电路结构和分析之后有机会的话再更新。

现阶段硬件的实现方式有数电(IBM、Qualcomm)、模电、数模混合(学界)、GPUs等等,还有各种不是基于硅半导体制程制作的神经元等的device方面的研究。

四、历史

Neuromorphic engineering由老祖宗Carver Mead提出

卡福·米德是加州理工学院的一名工程师,被公认为神经形态计算机之父(当然还发明了“神经形态学”这个词)

神经形态芯片的创意可以追溯到几十年前。加州理工大学的退休教授、集成电路设计的传奇人物卡弗·米德(Carver Mead)在1990年发表的一篇论文中首次提出了这个名称。

这篇论文介绍了模拟芯片如何能够模仿脑部神经元和突触的电活动。所谓模拟芯片,其输出是变化的,就像真实世界中发生的现象,这和数字芯片二进制、非开即关的性质不同。

Carver Mead是超大规模集成电路(VLSI)之父、定义了摩尔定律。

关于这个领域的著作 C. Mead, Analog VLSI and Neural Systems.Boston, MA, USA: Addison-Wesley, 1989.Analog VLSI and Neural Systems: Carver Mead: 9780201059922: Amazon.com: Books

Carver MeadCNS :: Carver Mead 中文介绍卡弗・米德-半导体人物

California Institute of Technology的Computation & Neural Systems group Computation & Neural Systems :: CALTECH

此外Jeff Hawkins在TED的演讲也值得一看

Jeff Hawkins: How brain science will change computing

TED演讲:Jeff Hawkins.大脑研究将改变计算机科学【高清中文字幕】

http://www.tudou.com/programs/view/tq07cQoYxB4/

摘其中有意思的一段:

后来这(大脑研究)成为我毕生的工作,我觉得我可以有所贡献,我尝试离开计算机行业而专注大脑研究。首先我去了MIT的人工智能研究院,我想,我也想设计和制作聪明的机器,但我的想法是先研究大脑怎么运作。而他们说,呃,你不需要这样做,我们只需要计算机编程。而我说,不,你应该先研究大脑。他们说,呃,你错了。而我说,不,你们错了。最后我没被录取。但我真的有点失望,那时候年轻,但我再尝试。几年后再加州的Berkley,这次我尝试去学习生物方面的研究。我开始攻读生物物理博士课程。我在学习大脑了,而我想学理论。而他们说,不,你不可以学大脑的理论,这是不可以的,你不会拿到研究经费,而作为研究生,没有经费是不可以的。我的天。

八卦:老师说neural network这个方向每20年火一次,之前有很长一段时间的沉寂期,甚至因为理论的不完善一度被认为是江湖术士的小把戏,申请研究经费都需要改课题名称才能成功。(这段为小弟的道听途说,请大家看过就忘。后来看相关的资料发现,这段历史可能与2006年Geoffrey E. Hinton提出深度学习的概念这一革命性工作改变了之前的状况有关。)

五、针对IBM这次的工作:

关于 SyNAPSE

美国国防部先进研究项目局的研究项目,由两个大的group组成:IBM team和HRL Team。

Synapse在英文中是突触的意思,而SyNAPSE是Systems of Neuromorphic Adaptive Plastic Scalable Electronics的简称。

Cognitive computing: Neurosynaptic chips

IBM produces first working chips modeled on the human brain

另一个SyNAPSE项目是由IBM阿尔马登实验室(位于圣何塞)的达尔门德拉·穆德哈负责。与四所美国大学(哥伦比亚大学,康奈尔大学,加州大学默塞德分校以及威斯康辛-麦迪逊大学)合作,穆德哈博士及其团队制造了一台神经形态学计算机的原型机,拥有256个“积分触发式”神经元,之所以这么叫是因为这些神经元将自己的输入累加(即积分)直至达到阈值,然后发出一个信号后再自行重置。它们在这一点上与Spikey中的神经元类似,但是电子方面的细节却有所不同,因为它们是由一个数字储存器而非许多电容来记录输入信号的。

Ref: A million spiking-neuron integrated circuit with a scalable communication network and interface. Paul A. Merolla et al. Science 345, 668 (2014); DOI: 10.1126/science.1254642

IBM 的网站上有一篇很好的报道供参考Cognitive computing: Neurosynaptic chips

中文的话36kr的这篇报道写得非常好 http://www.36kr.com/p/214445.htm

六、Reference

以上引用部分的reference以及推荐几篇看到的很有价值的干货资料:

The Economist有一篇长文非常详细 Neuromorphic computing: The machine of a new soul

(译言的翻译版 译者: gg1122译言网 | 计算机脱胎换骨)

生命科学研究快报 作者:于建荣 江洪波 神经形态芯片:仿生学的驱动力 --神经--新闻 --生物360 --中文生命科学界资讯站

36Kr 作者: boxi TrueNorth:IBM的百万神经元类人脑芯片

搜狐IT “人脑”芯片离我们有多远?

Nature Nicola JonesComputer science: The learning machines : Nature News & Comment

(译文 曾郁蓁 深度學習──人工智能的現在與未來)

國立臺灣大學科學教育發展中心 特約寫手方程毅 【神經科學】漫談神經形態工程學

神经网络和人工脑http://www.braincampaign.org/Common/Docs/Files/2766/chchap16.pdf

MITTechReview 罗伯特·霍夫(Robert D. Hof) 2014年全球十大突破技术:高通的神经形态芯片

学术论文:14年的两篇IEEE Press很好

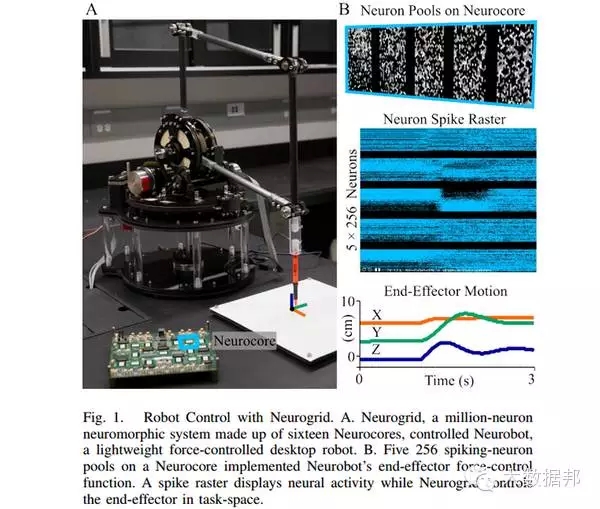

[1]B. V. Benjamin, P. Gao, E. McQuinn, S. Choudhary, A. Chandrasekaran, J.-M. Bussat, R. Alvarez-Icaza, J. Arthur, P. Merolla, and K. Boahen, “Neurogrid: A mixed-analog-digital multichip system for large-scale neural simulations,” Proceedings of the IEEE, vol. 102 no. 5, pp. 699–716, May 2014.

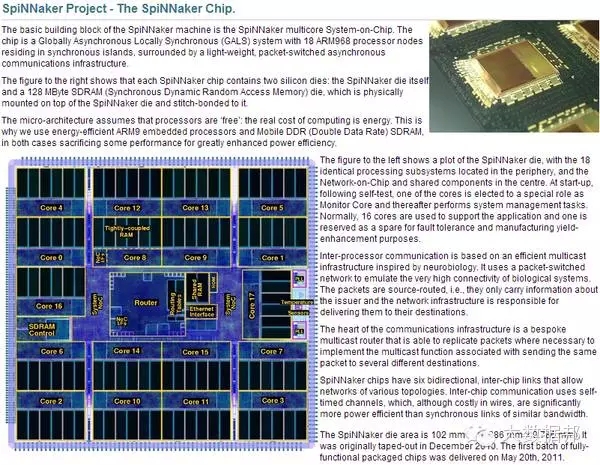

[2]Furber, S.B.; Galluppi, F.; Temple, S.; Plana, L.A The SpiNNaker Project.IEEE Proceedings, Vol:102, Iss:5 pp 652-665, May 2014. ISSN 0018-9219 IEEE Xplore Abstract

[3]以及IBM这次发表在Sceince上的这篇 Paul A. Merolla et al. A million spiking-neuron integrated circuit with a scalable communication network and interface. Science 345, 668 (2014); DOI: 10.1126/science.1254642Science Magazine: Sign In

[4]S Menon, S Fok, A Neckar, O Khatib, and K Boahen, Controlling Articulated Robots in Task-Space with Spiking Silicon Neurons, IEEE International Conference on Biomedical Robotics and Biomechatronics (BioRob), IEEE Press, pp nn-mm, 2014.

http://web.stanford.edu/group/brainsinsilicon/documents/Menon-BioRob.pdf

[5] Challenges for Brain Emulation: Why is Building a Brain so Difficult?

http://synapticlink.org/Brain%20Emulation%20Challenges.pdf

七、现有的部分业界学界神经形态芯片相关工作的介绍:

产业界:

IBM

高通 Zeroth

Introducing Qualcomm Zeroth Processors: Brain-Inspired Computing

新闻介绍Qualcomm’s Neuromorphic Chips Could Make Robots and Phones More Astute About the World

中文2014年全球十大突破技术:高通的神经形态芯片 (推荐)

Intel

上个月(2012),英特尔宣布启动了一项模拟人类大脑活动的技术研究工作。现在,该公司的工程师在预印本网站上递交了一篇论文,透露了神经形态芯片设计,模拟大脑神经元行为。他们的设计基于两项技术:横向自旋阀(lateral spin valves)和忆阻器。横向自旋阀是一种金属线连接的小型磁铁,能根据通过的电子自旋方向开关。忆阻器则是有记忆功能的非线性电阻器。英特尔工程师设计的芯片架构工作方式类似神经元,能复制出大脑处理能力。横向自旋阀工作的终端电压在毫伏内,远低于传统芯片,因此消耗的电力要少得多。

Intel Reveals Neuromorphic Chip Design

Solidot | 英特尔透露神经形态芯片设计

HRL Laboratories

HRL LaboratoriesHRL Laboratories : Laboratories : CNES : Center for Neural & Emergent Systems

Audience

Audience公司出于对神经系统的学习性和可塑性、容错、免编程、低能耗等特征进行了研究,研发出基于人的耳蜗而设计的神经形态芯片,可以模拟人耳抑制噪音,应用于智能手机。Audience公司也由此成为行业内领先的语音处理芯片公司。

Audience | Advanced Voice

相关技术论文Resources

Numenta

Numenta | New Era of Machine IntelligenceNumenta | NuPIC

CLA White Paper: CLA White PaperChinese Translation - Yu Tianxiang

Braincorporation(有高通投资)

Brain Corporation

学术界:

Standford 的Kwabena Boahen。

Boahen于1990年加入Mead在Caltech的实验室,现为stanford的Principal Investigator。Brains in Silicon

Kwabena Boahen TED演讲(有字幕)卡貝納‧博罕談論像人腦般運作的電腦

模拟人脑的神经形态计算方式渐成学界热点

Universität Heidelberg的 Karlheinz Meier教授

VISION: The "Spikey" ChipFACETS Material

Manchester 的SpiNNaker

Research Groups: APT

Institute of Neuroinformatics 苏黎世神经信息研究所

(由苏黎世大学与同城的一所工程院校ETH合办)Giacomo Indiveri INI Institute of NeuroinformaticsINI Institute of Neuroinformatics People

欧盟人脑计划

Home - The Human Brain Project

***现有的一些研究group的列表及比较(非常详细,推荐)

Comparison of Artificial Brain Projects

Brain Project Comparison

ps:其实IC业和CS的之间的代沟也并不是那么大,比如ISSCC 2015的conference theme就是SILICON SYSTEMS — SMALL CHIPS for BIG DATA。

8/21更新,(多图多视频预警)有知友反应看了这么多还有些地方不太懂,小弟这两天也在想各种方法怎么解释得更清楚,后来发现,以前看过的一个视频不就是Stanford的Boahen研究员(相当于教授)介绍他group的工作的么,这个视频很多知友也一定看过:

斯坦福大学公开课:健康未来 七个颠覆你思想的演讲:07 在芯片上搜索大脑

斯坦福大学:健康未来:七个颠覆你思想的演讲 7.在芯片上搜索大脑

http://v.youku.com/v_show/id_XNTE2OTczNDE2.html

(Boahen研究员07年在TED也有一个演讲,通俗易懂,卡貝納‧博罕談論像人腦般運作的電腦)不过这个公开课比较早期了,详细的解释以及的研究成果还请大家参考后文。

2014/9/27更

刚刚果壳上发表了一篇USC博后 @米糯牛(知乎ID) 的文章,推荐阅读: 芯片造脑:科幻照进现实?

果壳上还有两篇较早的文章 IBM:用超级计算机模拟人脑别了冯诺依曼,神经芯片几时来?

10/27更:路边社小道消息:IBM这颗芯片是在Samsung流的片,可能有用到一些特殊工艺。于是TSMC坐不住了(不论将来类神经芯片到底能不能火起来,现在一定要有积累,至少要知道对手在干什么),开始寻找这方面的学界合作了。

11/8更 在今天下午的腾讯“2014 WE大会”上IBM全球副总裁王阳介绍了IBM的神经元芯片。

新闻稿和视频如下:IBM王阳:计算的未来是把智慧注入设备

IBM王阳:计算的未来是把智慧注入设备

http://v.qq.com/cover/t/trg4ikjrtr4tols.html?vid=i0015g1aet7&start=38&ptag=tech_qq_com

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4307.html

摘要:并且在年中国第一次在专利总量超过美国,跃升至第一位,成为提交国际专利申请量最多的国家,从而打破了美国长达年的专利申请霸主地位。中国的技术创新仍处于大部分技术靠从外国购买技术专利的阶段。 要求 对 CSE512: Data Visualization 完成探索性...

摘要:本文内容节选自由主办的第七届,北京一流科技有限公司首席科学家袁进辉老师木分享的让简单且强大深度学习引擎背后的技术实践实录。年创立北京一流科技有限公司,致力于打造分布式深度学习平台的事实工业标准。 本文内容节选自由msup主办的第七届TOP100summit,北京一流科技有限公司首席科学家袁进辉(老师木)分享的《让AI简单且强大:深度学习引擎OneFlow背后的技术实践》实录。 北京一流...

摘要:所谓大数据及其相关技术在经历了高度重视详细甄别以及吐故纳新之后,实际成果很可能与我们的认知存在较大差异。他们将探讨与大数据相关的各类话题,内容涵盖对抗贩卖人口未来发展方向乃至人工智能前沿技术。 请大家不要再纠结于一块磁盘能保存多少数据或者企业到底会不会采用Hadoop。关于大数据的真正问题在于,企业用户将如何使用Hadoop、我们的系统到底能在智能化道路上走多远、我们又该如何保证这一切都处于...

摘要:最近,中美贸易战愈演愈烈,双方反复进行多轮谈判,有妥协也有分歧,其中最为著名的就是中兴事件。所以,这种中美贸易战设置的壁垒不仅对中国企业造成伤害,对美国企业同样也如此。最近,中美贸易战愈演愈烈,双方反复进行多轮谈判,有妥协也有分歧,其中最为著名的就是中兴事件。从中兴事件可以清楚看到,我国在科技创新、高端制造、关键核心技术领域跟美国的巨大差距,我们更多是作为一个设备和系统的集成商的角色存在着,...

摘要:第二次则是今年初,论文被深度学习盛会拒绝。表示遗憾乃至愤怒的人不在少数。他认为,使从其他学术实验室中脱颖而出的,是它的跨领域文化。腾讯也在筹建人工智能实验室,近期消息就会正式公布。 牛津大学和 DeepMind 的研究人员合作,开发出一款能够阅读唇语的系统,这个名叫 Watch, Attend and Spell(WAS)的软件在实际表现中远远超越了人类专家的水平。研究人员使用计算机视觉和机...

阅读 3364·2023-04-26 01:58

阅读 1061·2021-11-24 09:38

阅读 3391·2021-09-03 10:29

阅读 796·2021-08-21 14:10

阅读 1559·2019-08-30 15:44

阅读 3176·2019-08-30 14:10

阅读 3358·2019-08-29 16:32

阅读 1543·2019-08-29 12:48