资讯专栏INFORMATION COLUMN

小编写这篇文章的一个主要目的,主要是去给大家去做一些相关的一些介绍,涉及到内容的还是比较多的,比如如何去进行读取千万级的一些数据,并且将这些数据去自动录入到系统里面。录入到系统里面之后,怎么才能够导入到MySQL数据库呢?下面就给大家详细解答下。

序言

Python数据如何去进行读取MySQL数据库呢?这类工作在生活当中是比较的普遍的,涉及到的内容也是相关的一些python数据库,包括数据的听说读写等一些相关的数据工作。数据库的内容主要是涉及到mongodb、es,具体的一些相关内容,下面就给大家详细解答下。

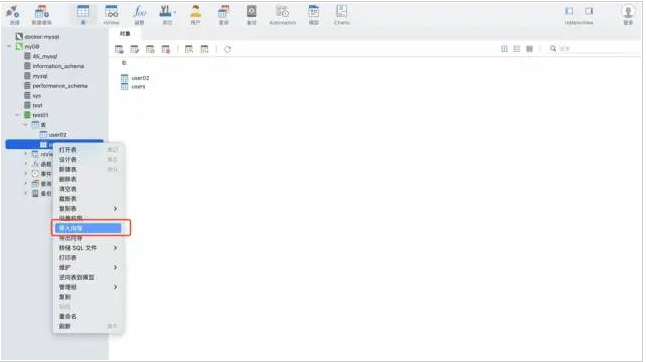

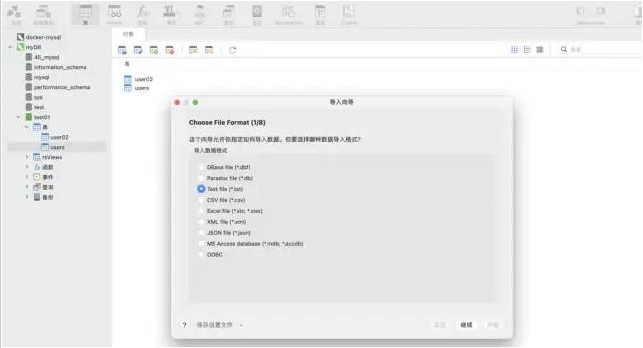

场景一:数据不需要频繁的写入mysql

使用navicat工具的导入向导功能。支持多种文件格式,可以根据文件的字段自动建表,也可以在已有表中插入数据,非常快捷方便。

场景二:数据是增量的,需要自动化并频繁写入mysql

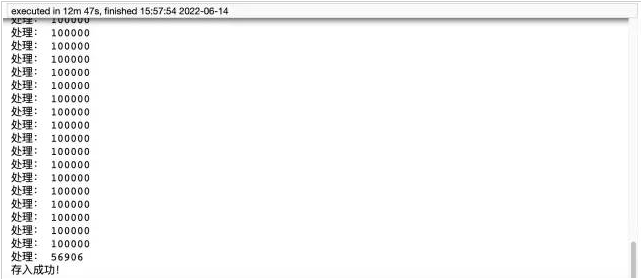

测试数据:csv格式,大约1200万行

import pandas as pd

data=pd.read_csv('./tianchi_mobile_recommend_train_user.csv')

data.shape打印结果:

方式一:python➕pymysql库

安装pymysql命令:

pip install pymysql

代码实现:

import pymysql

#数据库连接信息

conn=pymysql.connect(

host='127.0.0.1',

user='root',

passwd='wangyuqing',

db='test01',

port=3306,

charset="utf8")

#分块处理

big_size=100000

#分块遍历写入到mysql

with pd.read_csv('./tianchi_mobile_recommend_train_user.csv',chunksize=big_size)as reader:

for df in reader:

datas=[]

print('处理:',len(df))

#print(df)

for i,j in df.iterrows():

data=(j['user_id'],j['item_id'],j['behavior_type'],

j['item_category'],j['time'])

datas.append(data)

_values=",".join(['%s',]*5)

sql="""insert into users(user_id,item_id,behavior_type

,item_category,time)values(%s)"""%_values

cursor=conn.cursor()

cursor.executemany(sql,datas)

conn.commit()

#关闭服务

conn.close()

cursor.close()

print('存入成功!')

方式二:pandas➕sqlalchemy:pandas需要引入sqlalchemy来支持sql,在sqlalchemy的支持下,它可以实现所有常见数据库类型的查询、更新等操作。

代码实现:

from sqlalchemy import create_engine

engine=create_engine('mysql+pymysql://root:wangyuqing localhost:3306/test01')

data=pd.read_csv('./tianchi_mobile_recommend_train_user.csv')

data.to_sql('user02',engine,chunksize=100000,index=None)

print('存入成功!')总结

pymysql方法用时12分47秒,耗时还是比较长的,代码量大,而pandas仅需五行代码就实现了这个需求,只用了4分钟左右。最后补充下,方式一需要提前建表,方式二则不需要。所以推荐大家使用第二种方式,既方便又效率高。如果还觉得速度慢的小伙伴,可以考虑加入多进程、多线程。

最全的三种将数据存入到MySQL数据库方法:

直接存,利用navicat的导入向导功能

Python pymysql

Pandas sqlalchemy

综上所述,这篇文章就给大家介绍完毕了,希望可以给大家带来帮助。

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/128824.html

摘要:同盾技术总监张新波在第二期移动时代互联网金融的架构趋势中阐述了同盾是如何从零开始打造千万级实时风控云服务,具体介绍了同盾系统平台构建过程中主要需要解决的三大难题,以及解决这些问题的具体时实践过程。 同盾科技,是由阿里、Paypal 反欺诈专家创建的,国内第一家风险控制与反欺诈云服务提供商,其涉及领域包括电商、B2B、互联网金融、游戏等。同盾技术总监张新波在 UPYUN Open ...

摘要:摘要阿里云表格存储于近期功能再升级,升级后的表格存储支持对采集的数据进行持久化存储,其新增支持,以及最新发布的能够帮助用户轻松构建千万级和流系统。功能一支持对采集的数据进行持久化存储阿里云表格存储支持对采集的数据进行持久化存储。 摘要: 阿里云表格存储于近期功能再升级,升级后的表格存储支持对DataHub采集的数据进行持久化存储,其Python SDK新增支持Python 3.x,以及...

摘要:包括服务的自动化部署,以及链路监控等并未细说提及。结语诚然,整个服务架构可以轻松应对千万级并发。期望,整个服务架构能伴随公司继续成长壮大。 背景介绍 回顾 ShareSDK,顾名思义,分享的SDK组件,公司基于互联网,早期主要以ShareSDK起家。今日思来,很幸运,能陪着ShareSDK一起成长。 showImg(https://segmentfault.com/img/bV0Wo5...

阅读 1157·2023-01-14 11:38

阅读 1149·2023-01-14 11:04

阅读 982·2023-01-14 10:48

阅读 2507·2023-01-14 10:34

阅读 1236·2023-01-14 10:24

阅读 1116·2023-01-14 10:18

阅读 733·2023-01-14 10:09

阅读 812·2023-01-14 10:02