资讯专栏INFORMATION COLUMN

摘要:较大池化一个卷积神经网络的典型架构卷积神经网络的典型架构我们已经讨论过卷积层用表示和池化层用表示只是一个被应用的非线性特征,类似于神经网络。

这是作者在 Medium 上介绍神经网络系列文章中的一篇,他在这里详细介绍了卷积神经网络。卷积神经网络在图像识别、视频识别、推荐系统以及自然语言处理中都有很广的应用。如果想浏览该系列文章,可点击阅读原文查看原文网址。

跟神经网络一样,卷积神经网络由神经元构成,这些神经元带有可学习的权重和偏差(bias)。每个神经元接收若干输入,并对输入进行加权求和,然后通过一个激活功能将它们传递出去,再用一个输出作为反应。整个神经网络有一个损失函数,我们为神经网络开发的所有贴士和技巧,仍然适用于卷积神经网络。

那么,卷积神经网络是怎么不同于神经网络的呢?

卷积神经网络运行过量

这是什么意思?

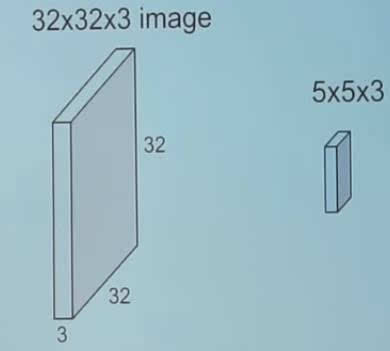

1.一个 RGB 图像的例子(称它为『输入图像』)

在神经网络中,输入是一个向量,但是在卷积神经网络中,输入是一个多通道图像(这个例子中的图像有 3 个通道)。

卷积

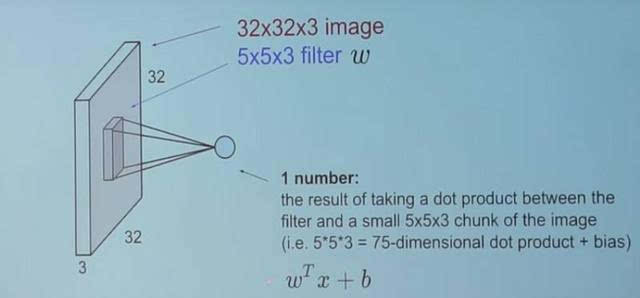

2.用滤波器来卷积图像

我们用了一个 5×3×5 的滤波器在整个图像上滑动,在滑动过程中,采集在滤波器与输入图像的块之间的点积。

3.看上去就是这样子

对于采集到的每个点积来说,其结果都是一个标量。

所以当我们用这个滤波器卷积一个完整的图像时会发生什么呢?

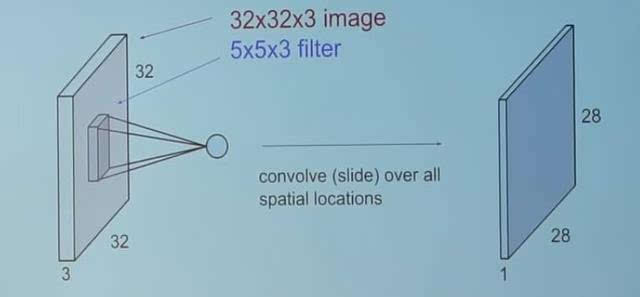

4.就是这个!

你可以自己想想这个『 28 』是怎么来的。(提示:有 28×28 个独特的位置,在这些位置上,滤波器可以被放在这个图像上)

现在,回到卷积神经网络

这个卷积层是卷积神经网络的主构建块。

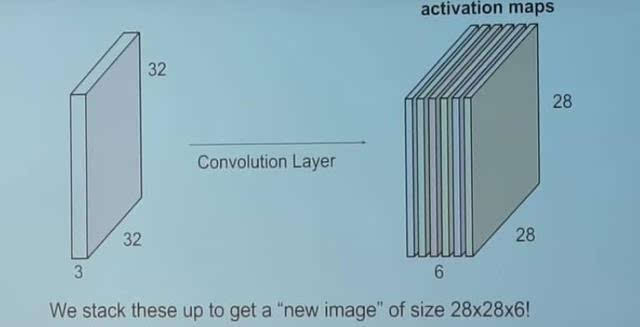

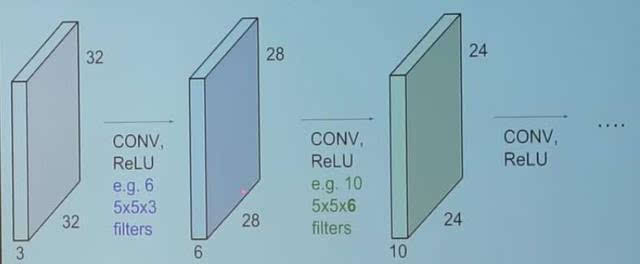

5.卷积层

卷积层包括一组独立的滤波器(该例子中有 6 个)。每个滤波器都独立地与图像卷积,我们以 6 个形状为 28×1×28 的特征图结束。

假设我们有一个序列卷积层。那么会发生什么呢?

6.序列卷基层

所有这些滤波器都被随机初始化,并成为我们的参数,随后将被这个网络学习。

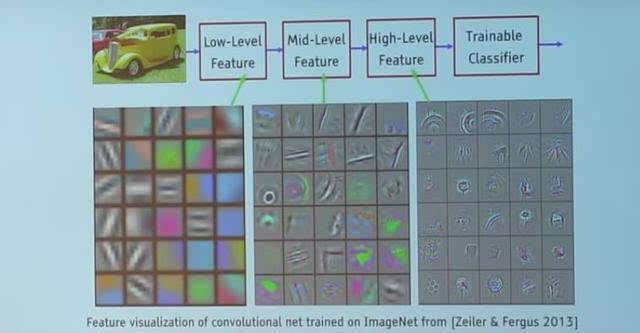

下面是一个训练过的网络的例子:

7.一个训练过的网络中的滤波器

看下最表层的滤波器(这些都是我们的5×3×5 的滤波器。)通过反向传播,他们将自己调整为彩色片和边缘的斑点。在我们深入到其他卷积层时,这些滤波器在做之前的卷积层的输入的点积。所以,它们正在采集这些较小的彩色片或边缘,并通过这些小的彩色片和边缘做出较大的彩色片。

看看图 4 ,并将这个 28×1×28 的网格想象成 28×28 个神经元。对于一个特定的特征图来说(在卷积带有一个滤波器的图像上接受的输出被称为一个特征图),每个神经元只连接这个输入图像的一小块,而且所有的神经元都具有相同的连接权重。因此,再次回到卷积神经网络和神经网络之间的差异。

卷积神经网络的一对概念:参数共享和局部连通性

参数共享,通过一张特定的特征图中所有神经元来共享权重。

局部连通性的概念是每个神经只连接一个输入图像的子集(不像神经网络中的所有神经元都完全连接在一起)。

这帮助减少了整个系统中的参数数量,让计算变得更有效。

为了简单一些,这里不讨论零填充(zero padding)的概念。有兴趣的可以自己去阅读相关资料。

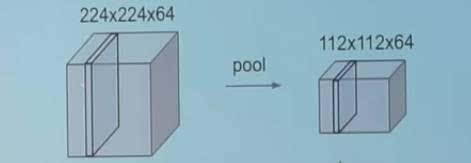

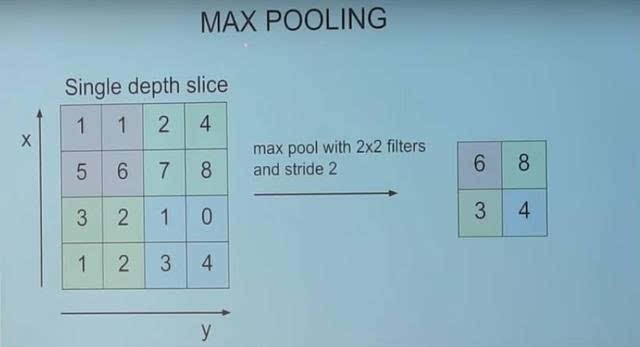

池化层

一个池化层是卷积神经网络的另一个构建块

池化

它的功能是通过逐步减小表征的空间尺寸来减小参数量和网络中的计算。池化层在每一个特征图上独立操作。

较大池化

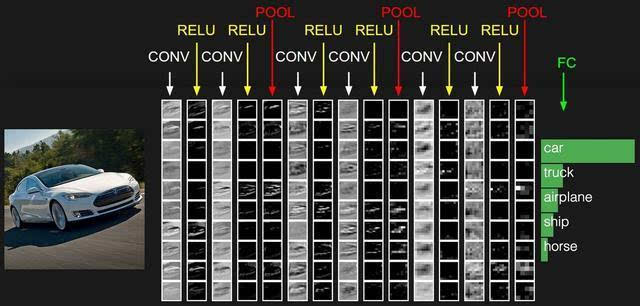

一个卷积神经网络的典型架构

卷积神经网络的典型架构

我们已经讨论过卷积层(用 CONY 表示)和池化层(用 POOL 表示)

RELU 只是一个被应用的非线性特征,类似于神经网络。

这个 FC 与神经元层完全相连在卷积神经网络的末端。完全连接层中的神经元连接着之前层中的所有激活,这在常规的神经网络中能看到,并以相似的方式运行。

希望你现在能理解一个卷积神经网络的这种架构了。这种架构还要很多变体,但是之前提到过,基本的概念都是相同。

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4366.html

摘要:这一切始于年的一篇论文,其使用了称为的算法用来提取感兴趣候选区域,并用一个标准的卷积神经网络去分类和调整这些区域。 本文详细解释了 Faster R-CNN 的网络架构和工作流,一步步带领读者理解目标检测的工作原理,作者本人也提供了 Luminoth 实现,供大家参考。Luminoth 实现:https://github.com/tryolabs/luminoth/tree/master/l...

摘要:本论文将尝试概述卷积网络的架构,并解释包含激活函数损失函数前向传播和反向传播的数学推导。本文试图只考虑带有梯度下降优化的典型卷积神经网络架构的制定。 近日南洋理工大学研究者发布了一篇描述卷积网络数学原理的论文,该论文从数学的角度阐述整个卷积网络的运算与传播过程。该论文对理解卷积网络的数学本质非常有帮助,有助于读者「徒手」(不使用卷积API)实现卷积网络。论文地址:https://arxiv....

摘要:显示了残差连接可以加速深层网络的收敛速度,考察了残差网络中激活函数的位置顺序,显示了恒等映射在残差网络中的重要性,并且利用新的架构可以训练极深层的网络。包含恒等映射的残差有助于训练极深层网络,但同时也是残差网络的一个缺点。 WRN Wide Residual NetworksSergey Zagoruyko, Nikos Komodakis Caffe实现:https://github...

摘要:考虑到这一点,我们将这种方法称为深度学习。这使我们回到原来的问题上我们不是因为深度模型而将其称为深度学习。这意味着具有个完全连接的层并且只有完全连接的层的神经网络将不再是深度学习模型,而某些具有少量卷积层的网络却可以称为深度学习。 不管你是业内人士还是业外人士,在人工智能以燎原之势发展的今天,相信对于AI、机器学习、深度学习这些词汇,你或多或都有一定的了解,而其中作为人工智能前沿的深度学习,...

阅读 1312·2021-09-26 09:55

阅读 3373·2019-08-30 15:55

阅读 1066·2019-08-30 15:53

阅读 2374·2019-08-30 13:59

阅读 2461·2019-08-29 13:08

阅读 1171·2019-08-29 12:19

阅读 3450·2019-08-26 13:41

阅读 511·2019-08-26 13:24