资讯专栏INFORMATION COLUMN

摘要:本文参考文献被引次数被引次数今天要讲的一个模型是由人工智能研究院提出来的完全基于卷积神经网络的框架,我在之前的推送中已经讲过好多次了,传统的模型是基于来实现的,特别是,这就带来了计算量复杂的问题。

本文参考文献:

Gehring J, Auli M, Grangier D, et al. Convolutional Sequence to Sequence Learning[J]. arXiv preprint arXiv:1705.03122, 2017.

被引次数:13

Dauphin Y N, Fan A, Auli M, et al. Language modeling with gated convolutional networks[J]. arXiv preprint arXiv:1612.08083, 2016.

被引次数:24

今天要讲的一个模型是由Facebook人工智能研究院提出来的完全基于卷积神经网络的seq2seq框架,seq2seq我在之前的推送中已经讲过好多次了,传统的seq2seq模型是基于RNN来实现的,特别是LSTM,这就带来了计算量复杂的问题。Facebook作出大胆改变,将编码器、解码器、注意力机制甚至是记忆单元全部替换成卷积神经网络,想法是不是简单粗暴?虽然单层CNN只能看到固定范围的上下文,但是将多个CNN叠加起来就可以很容易将有效的上下文范围放大。Facebook将此模型成功地应用到了英语-法语机器翻译、英语-德语机器翻译,不仅刷新了二者前期的记录,而且还将训练速度提高了一个数量级,无论是GPU还是CPU上。

在详细开始介绍Facebook的conv seq2seq模型之前,我们需要回顾一下Gated CNN,这个同样是Facebook在去年底提出来的用于语言建模的模型。

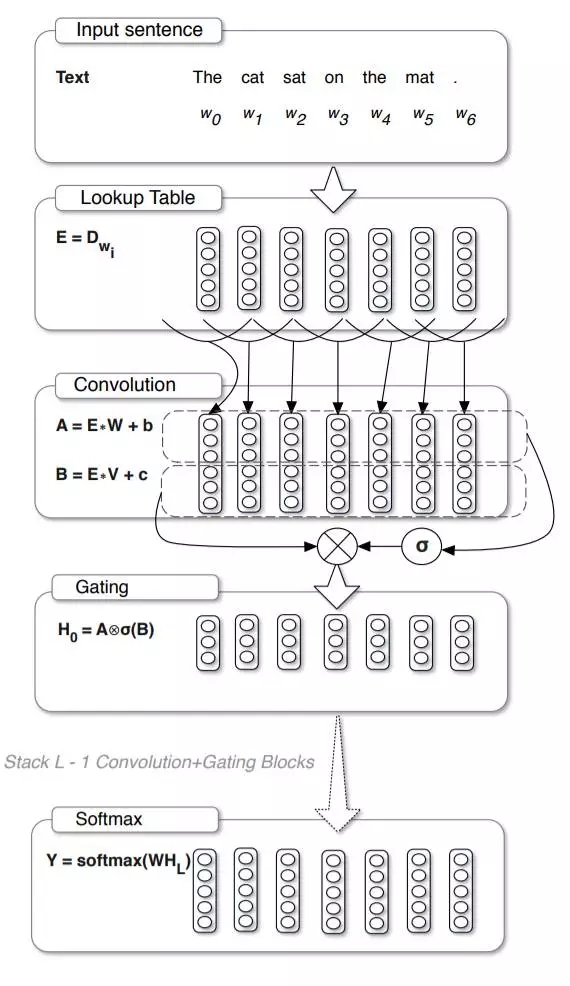

用于语言建模的Gated CNN模型如下图所示,可以看到,最上层的word embedding操作与传统的语言建模没有区别,紧接着就是对这些embedding向量划分时间窗并做卷积操作,注意这里使用了两个卷积神经网络,这两个神经网络中的其中一个通过激活函数一个与另外一个进行相乘,得到最终的输出。说到这里,应该有读者已经发现了其中一个卷积神经网络的功能就是充当了闸门的作用,即控制着多少有用的信息作为最终的输出。同时,实验结果也表明Gated CNN在WikiText-103上取得了较好的效果。

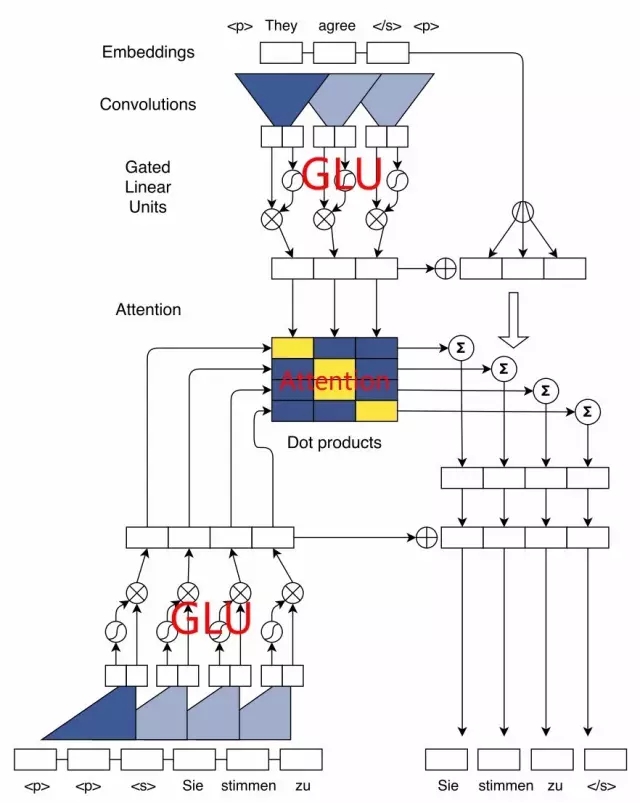

在conv seq2seq这篇文章中,也使用了Gated CNN以及Residual connection,文中的模型结构图如下所示,下面我来仔细说明一下这里的计算细节。

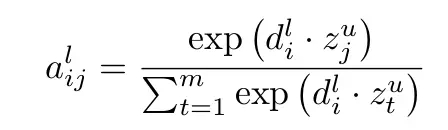

对于编码器,原始的单词首先需要经过embedding层得到其相应的embedding向量,然后将embedding向量作为Gated CNN的输入,这里需要注意的是,为了保证经过卷积操作之后与之前的输入长度一致,卷积需要做pad操作。模型中有两个地方都使用到了GLU(Gated Linear Unit),我在图中已经用红色字眼标出,编码器的embedding和解码器的embedding分别通过各自的GLU单元得到各自的分布式状态,将两个状态矩阵进行点乘即可得到注意力权重,图中已用红色字体Attention标出,具体的注意力权重的计算如下公式所示:

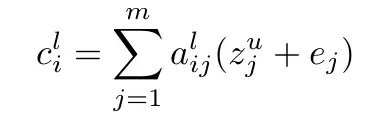

注意到图中编码器的embedding和编码器的状态进行相加,并且乘上注意力权重,得到的结果文中称之为条件输入c,这里我们可以对比传统的注意力机制,传统的注意力机制是直接将注意力权重和编码器的状态进行相乘,而这里引入了embedding量,文中解释是因为embedding可以在做预测的时候可以结合具体元素的信息,增加了位置感,条件输入c的计算如下图公式所示:

将条件输入c加上解码器的状态,即可得到输出序列的概率,以上就是conv seq2seq的模型结构。作者最终在机器翻译上相比其他RNN的模型速度提高了近10倍!

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4631.html

摘要:通过两年的发展,今天我们可以肯定地说放弃你的和有证据表明,谷歌,,等企业正在越来越多地使用基于注意力模型的网络。 摘要: 随着技术的发展,作者觉得是时候放弃LSTM和RNN了!到底为什么呢?来看看吧~ showImg(https://segmentfault.com/img/bV8ZS0?w=800&h=533); 递归神经网络(RNN),长期短期记忆(LSTM)及其所有变体: 现在是...

摘要:百度网盘提取码最近一直关注贪心学院的机器学习训练营,发现这门课讲的很有深度,不仅适合职场也适合科研人员,加入行业拿到高薪仅仅是职业生涯的开始。 百度网盘提取码:u6C4最近一直关注贪心学院的机器学习训练营,发现这门课讲的很有深度,不仅适合职场也适合科研人员,加入AI行业拿到高薪仅仅是职业生涯的开始。现阶段AI人才结...

阅读 3179·2021-10-27 14:16

阅读 2976·2021-09-24 10:33

阅读 2406·2021-09-23 11:21

阅读 3298·2021-09-22 15:14

阅读 906·2019-08-30 15:55

阅读 1771·2019-08-30 15:53

阅读 1872·2019-08-29 11:14

阅读 2255·2019-08-28 18:11